Transformer

簡單來說

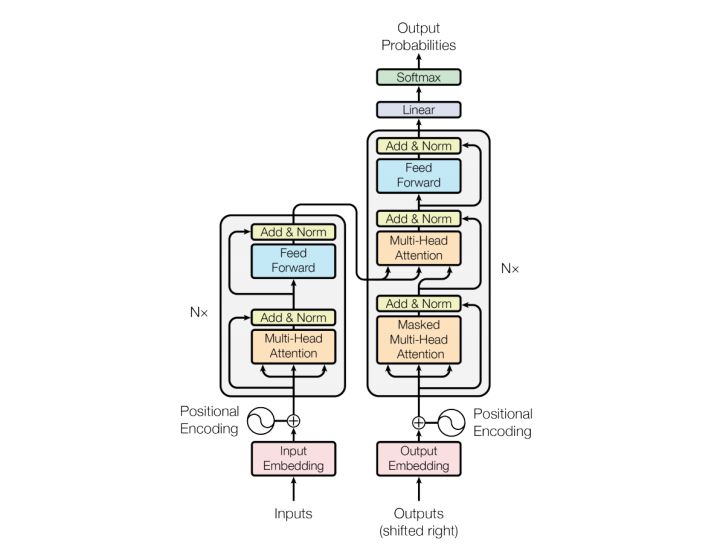

輸入 -> Encoding -> Decoding -> 輸出

原理

總覽

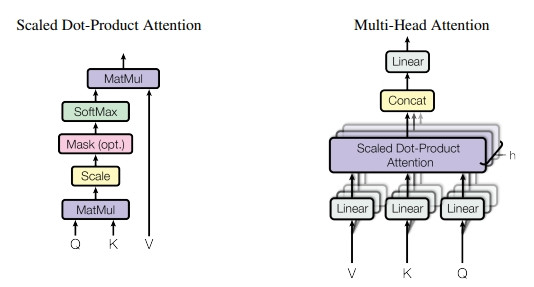

Self-Attention

Q : 原物

K : 相似參數

Q dot K : 相似度(attan)

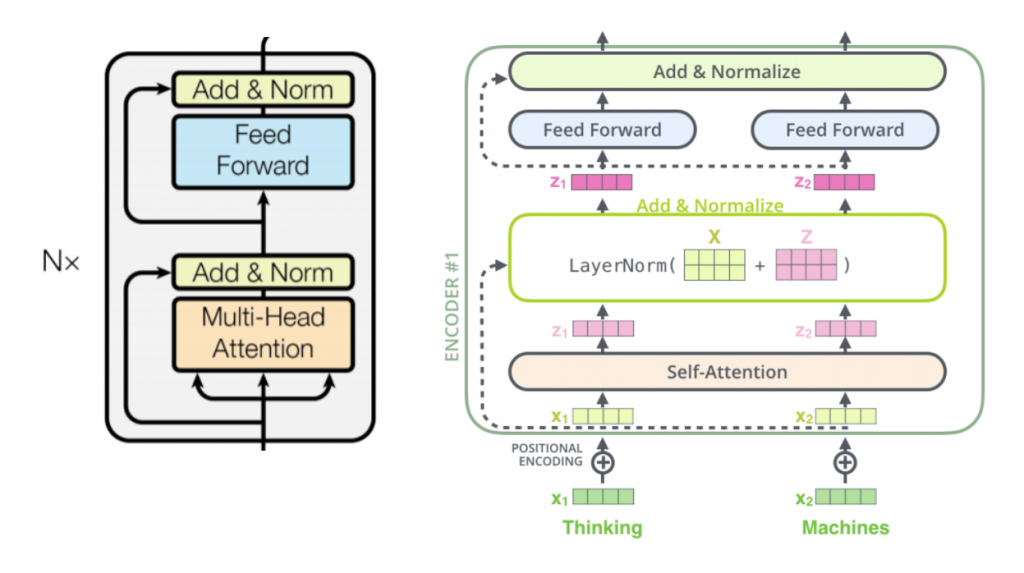

Add & Norm

- Residual

- LayerNorm

補充

- Embedding

例子 : 描述哆啦A夢

原本 : 藍色的、白色的、長得像狸貓、手和腳是圓形

Embedding : [123,234] 這代表上面所有形容詞

本部落格所有文章除特別聲明外,均採用 CC BY-NC-SA 4.0 許可協議。轉載請註明來自 OPH BLOG!

評論

ValineDisqus